Tema 8 Diagonalización de Endomorfismos

8.1 Introducción

Antes de entrar matemáticamente en el tema de la diagonalización de matrices cuadradas, se expondrán algunas de las aplicaciones que tienen las matrices diagonales

Recordad que una matriz diagonal es una matriz cuadrada que tiene ceros en todos sus elementos fuera de su diagonal principal

La factorización de una matriz dada \(A\) en función de otra matriz diagonal \(D\) permite resolver problemas de análisis y estudio de los sistemas eléctricos, vibraciones, economía, etc. que suelen venir modelados por ecuaciones diferenciales y en derivadas parciales

En esta factorización juegan un papel muy importante unos escalares denominados

Un tipo de aplicación de la diagonalización de matrices se encuentra en el análisis de la solución de un sistema dinámico a lo largo del tiempo.

Un sistema se caracteriza por el estado de un conjunto de \(n\) variables que lo determinan. Este conjunto se puede expresar como un vector de \(\mathbb{R}^n\) las componentes del cual expresan los valores de estas variables

\[(x_1,x_2,\dots,x_n)\]

Si el estado evoluciona a lo largo del tiempo modificando su valor a cada periodo (hora, día, mes…) es muy común que la relación entre los estados del sistema se presenten de forma recursiva:

- \(X_{p+1} = AX_p\) donde \(A\) es una matriz cuadrada de orden \(n\)

- \(X_p\) representa el estado del sistema en el periodo \(p\)

- \(X_{p+1}\) representa el estado del sistema en el periodo siguiente a \(p\)

Entonces basta con conocer el estado en el periodo inicial del sistema, \(X_0\), para poder calcular el estado del sistema en cualquier periodo

En efecto, si se conoce el estado inicial \(X_0\), se puede conocer:

\[X_1 = AX_0\] \[X_2 = AX_1 = A(AX_0) = A^2X_0\] \[\vdots\] \[X_n = A^nX_0\]

Por tanto, para conocer el estado del sistema en el periodo \(n\) es necesario el cálculo de la matriz \(A^n\). Este cálculo, como ya se habrá imaginado, es bastante complicado y es dificil no equivocarse.

En cambio, se simplifica considerablemente en el caso de que \(A\) sea diagonalizable

8.2 Diagonalización

En este tema consideraremos \(\mathbb{K}\)-espacios vectoriales donde \(\mathbb{K} = \mathbb{R},\mathbb{C}\) y \(f\in\text{End}(E)\), es decir, \(f\) es un endomorfismo de \(E\) en sí mismo.

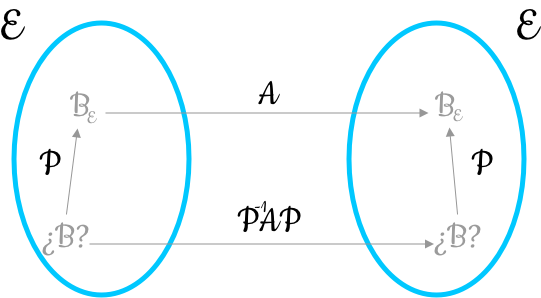

Podemos pensar que todas las matrices semejantes constituyen las diversas representaciones analíticas de un mismo endomorfismo \(f\) de un espacio vectorial \(E\) de dimensión \(n\) en diferentes bases de \(E\)

Así se plantea el problema de buscar la base de \(E\) en la cual \(f\) se presenta de la forma más sencilla posible.

Debido a las características tan buenas que presentan las matrices diagonales, se intenta encontrar una base de \(E\) en la cual \(f\) esté representada por una matriz diagonal, es decir, dada una matriz \(A\) en una base cualquiera, se va a buscar una matriz diagonal semejante a ella.

Este proceso recibirá el nombre de

No siempre es posible. Habrá que estudiar en qué condiciones existe una matriz así y respecto de qué base representará el endomorfismo.

En otras palabras, diagonalizar \(f\) es encontrar tal base. En tal caso, si \(B = \{v_1,\dots,v_n\}\) es la base que buscamos (base de veps asociados a los vaps \(\lambda_1,\dots,\lambda_n\) no necesariamente diferentes), la matriz asociada a \(f\) con respecto a esta base es la matriz diagonal \[A = \begin{pmatrix}\lambda_1 &\cdots &0\\ \vdots &\ddots&\vdots\\ 0&\cdots&\lambda_n\end{pmatrix}\]

ya que \(f(v_i) = \lambda_iv_i\) para todo \(i = 1,\dots,n\)

8.3 Vectores y valores propios de una matriz

La teoría que se verá a continuación está pensada para conseguir llegar a diagonalizar una matriz, pero no se ha de olvidar que esta matriz realmente representa un cierto endomorfismo en una determinada base.

- \(\vec{x}\ne 0\)

- Existe un escalar \(\lambda\in\mathbb{R}\) tal que verifica \(A\vec{x} = \lambda \vec{x}\)

Geométricamente, un vector propio \(\vec{x}\) es aquel que tiene la misma dirección que el vector \(A\vec{x}\) transformado por la matriz \(A\)

8.3.1 Cálculo de valores y vectores propios

Se parte de la ecuación matricial anterior

\[A\vec{x} = \lambda\vec{x}\]

que también se puede expresar como

\[A\vec{x}-\lambda\vec{x} = 0\]

O bien, \[(A-\lambda I)\vec{x} = 0\]

Esta ecuación representa un sistema homogéneo de \(n\) ecuaciones y \(n\) incógnitas, con matriz de coeficientes \(A-\lambda I\)

Si este sistema de ecuaciones de Cramer (\(n\) ecuaciones, \(n\) incógnitas, de rango \(n\) con \(\det(A-\lambda I)\ne 0\)) es compatible determinado, su única solución será la solución trivial \(\vec{x} = \vec{0}\)

Si, en cambio, el sistema ha de tener soluciones diferentes de la solución trivial, entonces el determinante \(\det(A-\lambda I)\) ha de ser 0. Es decir, existirán veps de la matriz \(A\) únicamente en el caso de que \(\det(A-\lambda I) = 0\)

El resultado de desarrollar el determinante \(\det(A-\lambda I)\) es un polinomio en la variable \(\lambda\)

Cuando la ecuación característica es de grado \(n\), tiene exactamente \(n\) soluciones, no necesariamente diferentes entre ellas.

Por tanto, es conveniente acompañar cada raíz del polinomio del número de veces que está repetida:

Un resultado análogo al anterior, pero referido a endomorfismos es el siguiente:

Ejercicio 1

Demostrar formalmente esta Proposición.

Una vez se han calculado todos los vaps tocará el conjunto de vectores propios asociados a cada vap. Para ello se resolverá para cada valor propio \(\lambda_i\) el sistema homogéneo siguiente

\[(A-\lambda_i I )\vec{x} = 0\]

8.3.2 Subespacio propio asociado a un valor propio

Se puede demostrar que

- Si \(\vec{x},\vec{y}\) son dos vectores propios cualesquiera de la matriz \(A\) asociados al mismo vap \(\lambda\), entonces su suma \(\vec{x}+\vec{y}\) también es un vector propio asociado al mismo valor propio \(\lambda\)

- Si \(\vec{x}\) es un vep de la matriz \(A\) asociada al vap \(\lambda\), también lo es cualquier otro vector de la forma \(\mu\vec{x}\) donde \(\mu\) es un escalar no nulo

Tened en cuenta el teorema de caracterización de un subespacio (la suma de dos vectores del subconjunto pertenece al subconjunto y el producto de un escalar por un vector del subconjunto es también del subconjunto)

8.3.3 Propiedades de los valores y vectores propios

- La suma de los \(n\) valores propios de una matriz es igual a su traza

- Los valores propios de una matriz y de su transpuesta coinciden

- El producto de los \(n\) valores propios de una matriz es igual a su determinante

- Dos matrices semejantes tienen la misma ecuación característica y por tanto los mismos vaps con la misma multiplicidad

- Una matriz triangular tiene como vaps los elementos de la diagonal principal

- A los vaps diferentes les corresponden veps linealmente independientes

- Un mismo vep no puede estar asociado a dos vaps diferentes

\[1\le \dim(H_i)\le n_i\]

\[1\le \dim(H_i)\le n_i = 1\Rightarrow \dim(H_i) = 1\]

Ejercicio 2

Demostrar formalmente este Teorema.

8.4 Endomorfismos y Matrices diagonalizables

8.4.1 Teorema de Diagonalización

Dicho de otra forma, el polinomio característico debe ser de la forma

\[p(x) = \det(A-xI) = (x-\lambda_1)^{n_1}\cdots(x-\lambda_r)^{n_r}\]

con \(n_1+\cdots+n_r = n\) y para cada \(i = 1,\dots,r\), \(n_i = \dim(H_{\lambda_i})\)

De esta forma, si la matriz tiene vaps diferentes \(\lambda_1,\lambda_2,\dots,\lambda_r\), uniendo las bases de todos los subespacios vectoriales propios \(H_{\lambda_1},H_{\lambda_2},\dots,H_{\lambda_r}\) se obtiene una base de \(E\)

\[\{B_{H_{\lambda_1}},\dots,B_{H_{\lambda_r}}\} = B_E\]

8.4.2 Cálculo de la matriz diagonal

En resumen, \(A\) es diagonalizable si todos los vaps pertenecen a los números reales o complejos y:

- Todos ellos son diferentes o bien,

- son múltiples y las multiplicidades algebraicas y geométricas son iguales para todos ellos

Además, la matriz \(D\) tiene como elementos de la diagonal principal los valores propios de la matriz \(A\) y cumplen la igualdad

\[D = (VP)^{-1}A(VP)\]

donde la matriz \(VP\) es la matriz que tiene por columnas los \(n\) vectores propios LI de la matriz \(A\)

Procedimiento para diagonalizar una matriz \(A\)

- Encontrar el polinomio característico

- Obtener las raíces de la ecuación característica, es decir, los vaps \(\lambda_i\) y sus multiplicidades algebraicas \(n_i\)

- Resolver para cada \(\lambda_i\) el sistema \((A-\lambda_i I)\vec{x} = \vec{0}\) para encontrar los veps y los subespacios propios

- Si \(n_i = \dim(H_{\lambda_i})\ \forall \lambda_i\), entonces la matriz es diagonalizable

- La matriz \(D\) tiene como elementos de la diagonal principal los vaps de la matriz \(A\) y \(D = (VP)^{-1}A(VP)\) donde la matriz \(VP\) es la matriz que tiene por columnas los \(n\) veps LI de la matriz \(A\) colocados siguiendo el mismo orden que los vaps en la matriz \(D\)

8.4.3 Diagonalización ortogonal

Las matrices reales simétricas son siempre diagonalizables. Es decir, tienen una base de vectores propios.

Y no solo eso, sino que siempre tienen una base de vectores propios ortonormales

\[Q^{-1} = Q^t\]

Esto equivale a decir que existe una matriz \(Q\) ortogonal tal que

\[Q^tAQ\] es una matriz diagonal formada por los valores propios de \(A\)

- Todos los vaps de la matriz son reales

- Los veps asociados a los vaps diferentes son ortogonales

- Tiene \(n\) veps. Es decir, es diagonalizable

- Tiene \(n\) veps ortonormales. Es decir, \(A\) es ortogonalmente diagonalizable